Mit dem sitequalityrater-Tool hat die linkbird-Truppe Anfang des Jahres ein gratis Tool vorgestellt, mit dem die SEO-Qualität von Websites gemessen werden kann. Wie sich das Tool im Beta-Stadium in der Praxis schlägt teste ich in diesem Artikel.

Laut den Machern von sitequalityrater.com ist das Tool „the easiest way to check the seo-quality of a website“. Ist es in der Praxis aber wirklich so einfach wie versprochen? Und wie sieht es mit der Qualität und den Bewertungskriterien aus?

Bedienbarkeit

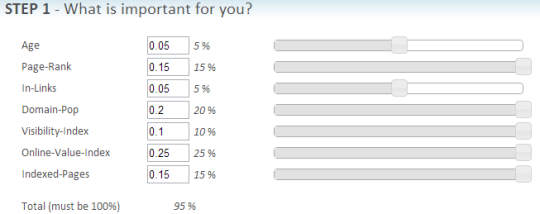

Der Aufbau der Seite ist sehr einfach und übersichtlich. Eine Registrierung ist nicht notwendig. Im ersten Schritt kann über Schieberegler die Gewichtung unterschiedlicher Faktoren zur Berechnung der SEO-Qualität bestimmt werden. Im zweiten Schritt können bis zu zehn URLs zur Bewertung eingetragen werden.

Schieberegler mit schlechter Usability: Die Werte 10% bis 25% befindet sich an der selben Position und 5% entspricht der Hälfte davon.

Bei der Festlegung der Gewichtung der einzelnen Faktoren stolpere ich direkt über zwei Usability-Steine. Möchte ich die Gewichtung ändern, kann ich das über die Eingabe einer Kommazahl erledigen (0.10 = 10%). Warum kann ich die Gewichtung denn nicht direkt in Prozent eingeben? Das würde die Eingabe erheblich beschleunigen. Der zweite Kritikpunkt sind die Schieberegler. Die sind quasi unbrauchbar, da sie wild hin und her hüpfen, wenn ich einzelne Werte festlegen will. Das Tool versucht wohl, nach jeder Änderung auf eine Gesamtwertung von 100% zu kommen. Es wäre sehr viel einfacher, wenn dieser Check nicht automatisiert vorgenommen werden würde, sondern über eine optische Hervorhebung der Gesamtprozentzahl (also zum Beispiel rot, wenn die Gesamtsumme nicht 100% entspricht). Auch der Maßstab der Position der Schieberegler funktioniert nicht korrekt. Hier besteht Verbesserungsbedarf.

Das Einfügen von URLs funktioniert problemlos: Per Copy & Paste bis zu zehn URLs untereinander in das vorgesehene Feld einfügen und per Klick auf „Get Sitequality“ die Auswertung anfordern.

Qualität der Ergebnisse

Als Testobjekte ziehe ich beispielhaft die 8 Social Media und SEO Blogs heran, die ich in einem älteren Artikel empfohlen habe. Die verbleibenden zwei Plätze fülle ich mit mizine von Viktor Dite (weil er auch mal im Zuge der Blogempfehlungen genannt werden möchte ;)) und meinem Blog. Die Blogs haben natürlich unterschiedliche Schwerpunkt-Themen, haben eine unterschiedliche Größe und sind auch unterschiedlich alt.

Für die gewählten Domains sieht das Ergebnis wie folgt aus:

Was die einzelnen Kennzahlen bedeuten, ist in einer Legende unterhalb der Auswertung sichtbar. Die relevanteste Kennzahl ist YPI (your personal comparison index), die die ermittelten Daten mit der festgelegten Gewichtung miteinander verrechnet.

Schaut man sich die erfassten Daten an, gerät man ins Grübeln. Wo kommen diese her? Wie aktuell sind sie? Für meine Domain (also media-affin.de) sind die Daten der Incoming Links, Domainpopularität sowie der indexierten Seiten falsch. Besonders fatal sind dabei die indexierten Seiten. Laut sitequalityrater ist keine der Domains im Index von Google vertreten, mit Ausnahme der SEO-Trainees. Aber nur eine (!) Seite im Index ist natürlich nicht richtig.

Lesetipp: Was ist der Sistrix Sichtbarkeitsindex?

Der Online Value Index (OVI) liefert Daten zu deutschen Websites aus dem XOVI-Tool. Für ausländische Website wäre dieser Wert vermutlich nicht brauchbar. Das heißt, dass letztendlich nur die Daten der Sichtbarkeit (VI) bleiben (sind die denn korrekt?) sowie PageRank und Alter der Domain. Die SEO-Qualität von Websites anhand dieser zwei beziehungsweise drei Faktoren fest zu machen ist aber nicht möglich. Darüber hinaus wäre es schön, weitere Faktoren zur Bewertung heranziehen zu können. Spontan würden mir da „Ranking für bestimmte Keywords in den Top 10“ und „Herkunft der Links“ einfallen.

Fazit

Die Idee von sitequalityrater.com ist super: Unterschiedliche Kennzahlen nach persönlicher Wunsch-Gewichtung in ein Ranking zur Bewertung der SEO-Qualität von Websites heranzuziehen. Für einen Kurzcheck wäre das super und würde Zeit sparen. Allerdings sind die zu Grunde gelegten Daten nicht korrekt / nicht aktuell und somit unbrauchbar.

Du bist aber ein aufmerksamer Leser ;) Danke!

Auch wenn ich nicht alle Kommentare direkt beantworte, lesen tue ich sie alle ;)

Hi Dominik,

vielen Dank für deinen Artikel! Dein Fazit fand ich besonders gelungen. Ich finde jedoch, das gerade bei der Neukundengewinnung solche Zahlen oftmals ein gutes Argument darstellen, inwieweit sich die Seiten des Kunden besser ranken lassen.

Kunden auf Grund von falschen Zahlen zu beraten ist hochgradig unseriös. Ich habe daher die beiden Links entfernt.

Habe gerade mal meine HP damit „getestet“, oder erst mal das Tool getestet. Mit den Reglern kann ich mir die HP „schön“ schieben und die Ergebnisse sind veraltet. Wenn man bedenkt das Alexa nur monatlich die Backlink-Seiten aktualisiert, hängt das Tool ja Monate hinterher.

Wo holt es sich denn die Daten, gibt es im www einen Datenfriedhof wo jeder grasen kann und die aktuellen Daten haben nur wenige?

Wieso kommen eigentlich jedes SEO-Tool auf andere Werte? Alexa, Seolytics, Majestic usw. usw. jeder hat andere Zahlen. Welchem Tool kann ich denn vertrauen und welches ist am aktuellstem?

Hi Andrea,

jedes SEO-Tool schickt seine eigenen Bots los, hat eigene Formeln zum Berechnen der Sichtbarkeit usw usf. Es gibt da keinen einheitlichen Standard. Deswegen kannst du auch nur die Daten aus dem selben Tool miteinander vergleichen.

Ich nutze am liebsten SEOlytics, das kannst du dir auch in einer gratis Variante erstmal anschauen.