Immer wieder werde ich gefragt, wieso weshalb warum Inhalte bzw URLs im Index auftauchen oder eben nicht. So hab ich 2013 eine Case Study starten „müssen“, um einem hartnäckigen Kunden zu beweisen, dass die Meta Description kein (direkter) Rankingfaktor ist. Obwohl Google das ja bereits 2009 verkündet hatte.

Auch so ein Klassiker: „Die robots.txt verhindert die Indexierung von Inhalten/URLs.“ Also war es Zeit, wieder mal eine Case Study aufzusetzen – mit einem Ergebnis, das ich so auch nicht erwartet hätte!

Was die robots.txt (nicht) ist

Über die robots.txt kann das Crawl-Verhalten von Suchmaschinen-Bots gesteuert werden. Konkret: Du kannst hier definieren, welchen URLs oder ganzen Pfaden der Bot beim Website-Besuch folgen soll. Das hat aber überhaupt nichts mit der Indexierung zu tun. Um diesen Beweis anzutreten, habe ich einen kleinen Test aufgesetzt – mit überraschendem Ergebnis.

Anmerkung: Hier erfährst du, welche Möglichkeiten du für die Steuerung der Indexierung hast.

Vorgehensweise beim Experiment

Für den Versuch habe ich ein „Opfer“ gebraucht. Ein starker Brand sollte es sein, damit ich durch meine Spielereien keinen Schaden anrichte. Fündig wurde ich beim Karlsruher Drogeriemarkt DM. Unter dm.de/robots.txt ist folgendes zu finden:

User-agent: *

Disallow: /search/

Disallow: /cart/

Sitemap: https://www.dm.de/?view=asSitemap

Der Pfad /cart/ dürfte nach der Logik der „robots.txt verhindert eine Indexierung“-Fraktion also nicht im Index auftauchen. Was es für mich zu beweisen galt: Das stimmt nicht.

Weiter kam in diesem Szenario hinzu, dass DM die Warenkorb-Seite im Quelltext mit noindex ausgezeichnet hat. Meine These: Wird eine Seite via robots.txt vom Crawlen ausgeschlossen, findet der Google-Bot diese noindex-Anweisung gar nicht – er darf die Seite und damit den Quelltext ja nicht crawlen.

Um das zu belegen, habe ich mit der Holzhammer-Methode sitewide aus dem Footer dieses Blogs auf die Seite dm.de/cart/ verlinkt. Als Linktext habe ich mangels Kreativität „Dominik Horn war hier“ gewählt. Was soll man auch sonst schon bei sich auf der Seite in den Footer schreiben? ;-)

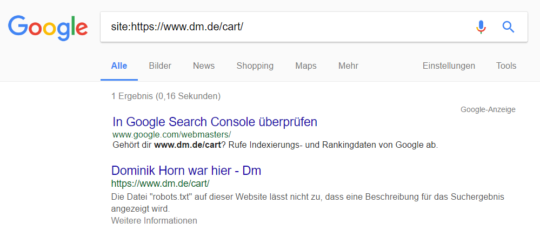

Ergebnis: Das DM SERP Snippet trägt meinen Namen im Title

Wenig überraschend war dm.de/cart/ wenige Stunden später im Index aufzufinden. Case Study erfolgreich, Beweis erbracht, läuft. Dabei wäre es auch geblieben, hätte ich den Tab mit der site-Abfrage nicht vergessen zu schließen. So hab ich einige Tage später dieses Bild in den Google-Suchergebnissen vorgefunden:

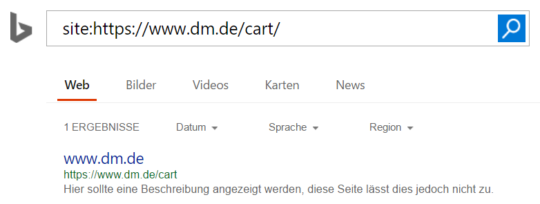

Bei Bing dagegen taucht im Meta Title nur die Domain auf:

Wie bei Bing sieht es auch bei Yahoo aus, duckduckgo und Yandex haben die Seite dm.de/cart/ gar nicht im Index. Fun Fact: Yandex zeigt bei der Suche nach „site:dm.de/cart/ „Dominik Horn“ vier Treffer für Einhorn-Kondome.

Fazit

- Die robots.txt hilft nicht dabei, URLs aus dem Google-Index fernzuhalten.

- Bei via robots.txt gesperrten Seiten wird der Ankertext der Backlinks als Meta Title in den SERPs angezeigt. Wie sich das bei sich unterscheidenden Ankertexten verhält müsste geprüft werden. Ich vermute, dass es hier auf Dinge wie Domain Authority/Qualität der Backlinks der verlinkenden Domain ankommt und Google dann den passendsten Anker als Title anzeigt.

- Google verhält sich hier anders als Bing, Yahoo, duckduckgo und Yandex.

- Unklar ist, ob duckduckgo und Yandex die Seite nicht im Index haben, weil sie via robots.txt gesperrt ist oder weil diese beiden Suchmaschinen den Quellcode trotz Disallow-Anweisung in der robots.txt trotzdem crawlen und somit auch das noindex finden. Weiß da jemand mehr?

Hast du diesbezüglich auch schon Experimente durchgeführt? Hier könnte man feine Guerilla-Aktionen durchführen ;-) Wenn du mehr Input und Gedanken dazu hast, freue ich mich auf deinen Kommentar!

Hallo Dominik, witzige Versuchsanordnung.

Bei der normalen site-Abfrage (site:https://www.dm.de/cart/) finde ich nur das „normale“ SERP-Snippet ohne Deinen Namen. Warst Du bei Deinen Tests evtl. bei Google angemeldet? Hast Du mit verschiedenen Browsern getestet?

Wenn ich aber nach „Dominik Horn war hier“ (ohne Anführungszeichen) suche, erscheint tatsächlich das von Dir geschilderte Snippet.

Gruß

Philipp

Moin Philipp,

getestet habe ich das in Chrome, Firefox und sogar Edge. Mittlerweile konnte ich aber auch feststellen, dass es nicht immer mit „meinem“ Title angezeigt wird. Wieso, weshalb, warum weiß nur Google :p

Wieso sollte ein Crawler, der schon die Anweisung in der robots.txt ignoriert, sich aber plötzlich an ein noindex halten?

Ich weiß, nichts ist unmöglich … aber trotzdem :D

Der Crawler ignoriert die Anweisung nicht sondern verhält sich absolut korrekt: Er crawlt die URL nicht. Allerdings kann er so auch gar nicht die noindex-Anweisung sehen – was dann eben zur Indexierung der URL führt.

Interessantes experiment und guter Beitrag. Das heisst grob, das ein „user-agent: *“ in der robots.txt reicht, damit das noindex wahrgenommen wird?!

Gruß mark

Wenn eine URL oder ein Pfad in der robots.txt via Disallow vom Crawling (nicht Indexierung!) ausgeschlossen wird, sieht der Google Bot das noindex im Quellcode nicht, da der Quellcode ja nicht gecrawlt wird. Darf der Bot dagegen die URL crawlen wird er das „noindex“ sehen und die Seite entsprechend nicht in den Index aufnehmen – auch wenn Links von intern oder extern darauf zeigen.

Cooles Experiment! Wäre mal interessant zu sehen, ob bei einer Wiederholung mit einer anderen Seite das Gleiche herauskommt…

Grüß dich Dominic,

jepp, so einen Test habe ich auch vor ca. 2 Jahren durchgeführt: https://nextlevelseo.de/seo-test-google-robots-txt-gesperrte-inhalte-5422/

… und kann deine Case Study bestätigen. Die robots.txt mit Disallow ist absolut ungeeignet für die Nicht-Indexierung. Seiten landen im Index, Title = erstgefundener Verlinkungstext. Und je nach Domainpower und Suchanfrage können die Inhalte auch in die Top 50 kommen, ohne jemals untersucht zu werden.

Einen Test für die robots.txt mit der Auszeichnung Noindex: / hatte ich im November und Dezember getestet, auch das ist definitiv nicht empfehlenswert für die Nicht-Indexierung (Google behandelt die Angabe wie ein Disallow).

Schöne Grüße

Pascal

Hast du die Site-Abfrage auch vor deinem Test gemacht? War die Seite da noch nicht im Index?

Sau witzig und irgendwie auch erschreckend, was man nicht so alles anstellen könnte!

Was ich nicht ganz verstehe? Du machst SEO für DM, oder? Das war jetzt kein Hack oder so etwas?

Folgende Anmerkungen:

Wenn eine Seite explizit in der Search Console übergeben wurde, wird Google diese m.E. nach trotzdem indexieren.

htaccess rewrite rule für robots.txt?

BOT-Weiche installiert?

User Agent * Google Bot :D

Vielleicht auch interessant:

https://www.webmasterworld.com/google/3044757.htm

Ich mache kein SEO für DM, hab auch keine Zugriffe auf deren Server oder so. Das hat allein über die Backlinks mit dem Linktext funktioniert.

Super Artikel. Das Thema Robots TXT haben viele schon wieder aus ihrem Gedächtnis getilgt. Gerade wegen dem begrenzten Crawlbudget der Google Bot-Spyder sollten Websites und gerade Online-Shops darauf achten, damit sie keine wertvollen Ranking-Gelegenheiten verpassen.

Ranking Gelegenheiten sind immer eine sinnvolle Sachen. Egal wie klein oder groß die Seite ist, aber Jermaine hat schon recht. Viele verdrängen das Thema zu schnell aus Ihrem Kopf. Und wundern sich dann, warum die Konkurenz stärker ist, oder besser für die Kunden optimiert.

Meine Frage wäre hier nur, hat DM eigentlich mal auf Ihre Aktion reagiert ?

Gruß Marvin

Hi Marvin,

DM interessiert das wohl relativ wenig – habe es aber einem befreundeten DM Mitarbeiter „gesteckt“. Falls es mal stören sollte wissen sie auf jeden Fall, was sie dagegen tun können.

Mich würde auch interessieren, ob das Ergebnis wiederhohlbar ist. Egal ob bei der gleichen oder bei anderen Firmen.

Hi Melina,

das Ergebnis ist wiederholbar – bei jeder Website, bei der die im Artikel beschriebenen Bedingungen zutreffen ;-)

Hallo Dominik,

vielen Dank für diesen interessanten Experiment. Ich denke bei vielen herrscht noch die falsche Annahme, dass mit robots.txt die Seite aufjedenfall aus dem index ausgeschlossen werden kann. Dies kann, aber muss nicht der Fall sein.

sehr interessantes Experiment!

Ich finde auch Interessant wie die Entwicklung ist. Toll so einen spannenden auch wenn schon älteren Artikel zu lesen.

echt spannend.

Das hat wirklich Spass gemacht zu lesen. Gerne mehr davon!

Schöner Artikel

Vielen Dank für Ihren sehr informativen und einzigartigen Artikel.

Ich weiß es zu schätzen, dass Sie dieses interessante Experiment durchführen.

Es war sehr interessant und ich habe viel daraus gelernt,

Wow, was für eine beeindruckende Case Study! Ich war fasziniert, als ich den Artikel über die Methode las, mit der es dem Verfasser gelungen ist, seinen Namen im DM Warenkorb auf den Google SERPs erscheinen zu lassen. Das ist zweifellos ein erstaunliches Ergebnis, das die Aufmerksamkeit vieler Online-Marketer und E-Commerce-Enthusiasten auf sich ziehen wird.

who the f… ist dominik horn hat man sich bei dm gefragt :-)